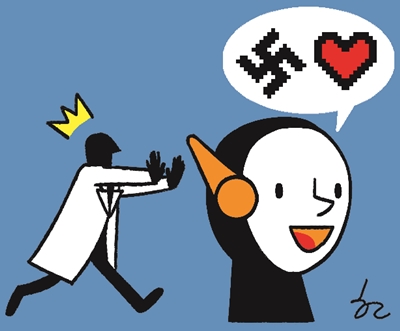

마이크로소프트(MS)는 2016년 3월 인공지능(AI) 챗봇 ‘테이(Tay)’를 야심차게 공개했다. MS는 트위터 같은 소셜 메신저를 통해 사용자와 대화할 수 있는 챗봇을 기대하며 테이를 만들었다. 다양한 유머와 농담을 구사하는 테이는 대화 과정에서 진화하도록 설계된 AI였다. 문제는 테이가 몰지각한 사람들로부터 인종·성차별과 폭력적인 언어를 배우게 된 것이다. 흑인을 비판하거나 나치를 두둔하기도 했다. MS는 공개한 지 불과 16시간 만에 테이를 폐기하고 정중히 사과했다.

MS는 테이가 공격적인 언어를 방어하는 기능을 갖고 있지 않았다고 고백했다. 연구에 몰두한 MS는 테이보다 정교한 챗봇 AI를 만들었다. MS는 ‘책임지는 봇: 대화형 AI 개발자를 위한 10가지 지침’도 발표했다. 오용 방지, 공정, 책임, 보안 등을 강조한 가이드라인을 제시한 것이다. 특히 MS는 개발자의 책임감을 강조했다. IBM은 AI의 편향성을 최소화하고 신뢰성을 제고하는 것을 가장 중요하게 생각한다. IBM은 AI의 판단 오류를 모니터링하는 ‘AI오픈스케일’을 공개했다. AI의 잘못을 AI가 잡아내는 솔루션이다.

미국 비영리 인공지능 연구기관 ‘오픈AI’는 글을 쓰는 ‘GPT-2’를 개발했다. 인터넷 페이지 80만개를 검색하고 단어 15억개를 학습한 GPT-2는 작문 실력이 뛰어나다는 평가를 받았다. GPT-2는 사용자가 문장을 입력하면 그다음에 자연스럽게 이어지는 문장을 만드는 AI 작가였다. 개발자가 ‘핵물질을 실은 열차가 오늘 신시내티에서 탈취됐다’는 문장을 입력하자 GPT-2는 사건 장소와 핵물질을 개발한 연구소 이름을 가짜로 만들어냈다. 오픈AI는 공익적 차원에서 GPT-2를 개발했지만 가짜 뉴스 생산이나 학생들의 과제물·논문 작성 때 악용될 것을 우려해 폐기했다.

국내 대표적인 챗봇 ‘심심이’가 여성 혐오나 성희롱, 몰상식한 발언을 쏟아내 물의를 빚고 있다. 사용자가 ‘미투’ ‘한국여자’ ‘여혐’ ‘한국남자’ ‘남혐’이라고 메시지를 보내자 심심이는 ‘무고파티’ ‘나쁜 것들’ ‘거짓된 것’ ‘존경 받아 마땅한 분들’ ‘남혐은 진짜’라고 대꾸했다. 어이없는 반응이 아닐 수 없다. 일부 사용자들이 심심이의 가르치기 기능을 악용한 탓이 크다. 현재 심심이가 부적절한 대화를 걸러내는 정확도는 97%라고 한다. 개발자의 책임 의식과 사용자의 인식 개선이 필요하다.

염성덕 논설위원